С понятием «индексация» сталкиваются все вебмастера. Чтобы сайт увидели поисковые системы, он должен попасть в базу данных. Для этого поисковые роботы просматривают содержимое страниц и передают данные в индекс. Ресурс проверяется по ряду параметров и определяется его место в выдаче. Но есть случаи, когда необходимо скрыть сайт от индексации.

Примеры, когда сайт нужно закрывать от индексации

Строгие алгоритмы краулеров не могут учитывать частные моменты. Факторы времени, обстоятельств, творческие противоречия, оригинальность замысла вебмастера. Запретить роботам прийти на страницы, когда вы не готовы, нельзя, а вот написать запрет на просмотр файлов можно. Вот причины, чтобы отключить индексацию сайта, отдельных страниц, блоков:

- Сайт в работе. Есть пустые страницы, меняется дизайн, ссылки не работают или отсутствуют. Вы не хотите, чтобы ваш проект люди увидели таким.

- Есть два варианта ресурса. Один основной, а дубликат – для тестирования нововведений. Краулеры такое совпадение посчитают плагиатом, что повлияет на ранжирование в поисковой выдаче.

- Информация личная или служебная. Например, корзина клиента, его адрес, телефон. Может быть, секретные данные, которые нельзя делать общедоступными по закону или в целях безопасности.

- Есть информация, которую невозможно сделать уникальной: законы, инструкции, календари, цитаты и т.д.

Возможны другие причины закрыть сканирование роботами. Процесс смены домена или сайт только для друзей. Ссылки, оставляемые в комментариях, тоже не желательно индексировать.

Способы запрета индексирования сайта или страницы

Вариантов много. Попробуем их структурировать.

| Инструмент / Что нужно скрыть |

Текстовый файл robots.txt | Метатег robots | В базовых настройках WordPress | Служебный файл .htaccess | При помощи javascript |

| Весь сайт | |||||

| Страницу | |||||

| Тип файлов | |||||

| Файл | |||||

| Текст | |||||

| Часть текста | |||||

| Ссылку |

Запрет индексирования сайта, раздела или страницы

Итак, есть необходимость не допустить роботов на сайт. Смотрим таблицу и выбираем подходящий способ. Выбор зависит от задачи и возможностей инструмента. Начнем со случая, когда цель не меньше страницы.

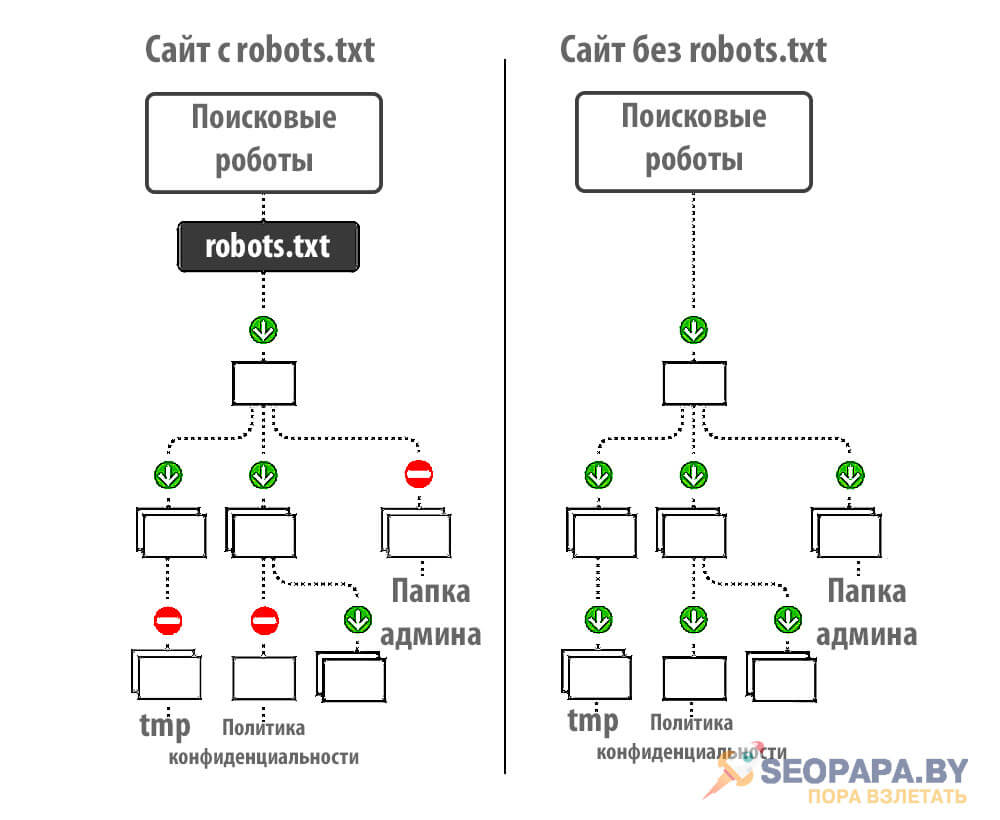

Инструмент robots.txt

В программе блокнот создаем файл с названием robots и расширением .txt. Чтобы закрыть сайт от индексации с помощью robots.txt, вводим в этом файле обращение ко всем поисковым роботам User-agent: * и команду Disallow: /. Сохраняем и загружаем файл на сервер в корневую папку через файловый менеджер или админпанель. Этот простой алгоритм поможет запретить индексацию сайта целиком.

- User-agent: *

Disallow: /

Если надо закрыть доступ к сайту определенным поисковым системам, то в обращении вместо User-agent: * нужно поставить имя поисковых роботов данной системы. Например: User-agent: Yandex. И для каждого нежелательного поисковика делать свое обращение отдельной строкой.

Для скрытия раздела по этому алгоритму, после команды Disallow: / пишется razdel. Если нужно спрятать от роботов одну страницу, то после Disallow: / вставляем ее url-адрес.

Важно не увлекаться. Максимальное количество файлов robots.txt — 1024. Но большое количество запретов, приведет к их игнорированию.

Закрыть страницу и сайт с помощью метатега robots

Если у вас есть доступ к редактированию исходного кода, то мета-тег robots, прописанный в head перед <title> ,тоже может сообщить поисковикам о нежелательности индексации. В метатеге используют команды:

- noindex, скрывает главную страницу, или при дополнении, поможет не индексировать содержимое страницы. Она не появится в результатах поиска;

- nofollow – это для ссылок. Команда показывает роботу, что переходить по ним не надо. Но ссылки могут попасть в индексацию, если информация о них есть в других источниках;

- none – заменяет обе предыдущие команды вместе. То есть none = nofollow + noindex.

Запрет на индексацию сайта robots работает для страниц, текста, ссылок. Но если вам нужно закрыть сайт от индексации целиком, то лучше воспользоваться инструментом robots.txt .

Закрыть сайт от индексации на WordPress

Уже при начальной настройке понятно как закрыть свой проект от индексации WordPress. Все пользователи WordPress видят это окошко в настройках. Многие разумно устанавливают там галочку, закрывающую ресурс от сканирования. А сделав сайт, убирают ее. При необходимости запрет можно вернуть. Открыли вкладку «Настройки», в списке выбрали «Чтение» и в самом низу в окошке «Попросить поисковые системы не индексировать сайт» поставили галочку.

Запрет индексации сайта с помощью .htaccess

Первый вариант – прописать запрет для каждого поисковика. Вот так: SetEnvIfNoCase User-Agent «^Googlebot» search_bot?01. И так далее.

- SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent «^Yahoo» search_bot

SetEnvIfNoCase User-Agent «^Aport» search_bot

SetEnvIfNoCase User-Agent «^msnbot» search_bot

SetEnvIfNoCase User-Agent «^spider» search_bot

SetEnvIfNoCase User-Agent «^Robot» search_bot

SetEnvIfNoCase User-Agent «^php» search_bot

SetEnvIfNoCase User-Agent «^Mail» search_bot

SetEnvIfNoCase User-Agent «^bot» search_bot

SetEnvIfNoCase User-Agent «^igdeSpyder» search_bot

SetEnvIfNoCase User-Agent «^Snapbot» search_bot

SetEnvIfNoCase User-Agent «^WordPress» search_bot

SetEnvIfNoCase User-Agent «^BlogPulseLive» search_bot

SetEnvIfNoCase User-Agent «^Parser» search_bot

Второй вариант запрета индексации сайта htaccess – прописывается код доступа по паролю.

И еще можно в .htaccess сделать так, чтобы при обращении к странице поисковиком, появлялось уведомление об ошибке 403 или 410. 1ErrorDocument 404 http://site.ru/404

Запрет индексирования контента страницы

На страницах могут содержаться блоки, картинки, текст и другие элементы. Скрыть их помогут уже названные инструменты.

- Файл robots.txt с командой Disallow: /, после которой прописывается, что нужно скрыть.

- Мета-тег robots с исполнительными командами noindex, nofollow, none.

- На WordPress есть возможность скрыть элемент контента или страницу функцией редактора «Видимость». Последовательно нажимаем: «Изменить», «Защищено паролем», «Ок».

- Еще применяется технология SEO Hide с помощью языка JavaScript. Текст пишется на этом языке, а скрипт прячется через robots.txt .

Заключение

Возможностей для скрытия контента от поисковиков достаточно. Каждая из них имеет свои плюсы и особенности. Применяя любой способ, связанный с написанием кода, важно делать это внимательно. Допущенные ошибки могут дать результат обратный ожидаемому. Многие проблемы можно решить без запрета. Например, закрывать ли фильтры на сайте от индексации? Не обязательно – грамотные скрипты оставят на странице только один параметр, а остальные будут появляться по клику. К каждому вопросу оптимизации надо подойти индивидуально, особенно пока опыта еще нет.